Crédits photos : Palestinian News & Information Agency (Wafa) in contract with APAimages, CC BY-SA 3.0 <https://creativecommons.org/license...> , via Wikimedia Commons

Le « Saint Graal », c’est par ce terme que des officiers israéliens décrivent le système d’intelligence artificielle « Lavender » (Lavande) utilisée par l’armée israélienne depuis le 7 octobre. Dans une enquête menée par +972mag, on apprend que cette IA a joué un rôle central dans les bombardements sur Gaza en permettant à l’armée de répertorier environ 37.000 cibles potentielles, considérées comme membres du Hamas, et en élargissant le nombre de « victimes acceptables ».

Le journal en ligne avait déjà révélé en novembre dernier l’utilisation d’une autre intelligence artificielle, « The Gospel » (L’évangile), dans les offensives génocidaires de Tsahal. Cette IA a permis à l’armée israélienne de cibler des bâtiments où il y aurait eu des activités du Hamas pour ensuite mener des frappes aériennes, faisant des milliers de morts sur le passage.

Des milliers de « dommages collatéraux » : Israël élargit le nombre de victimes « acceptables » dans les frappes aériennes

Selon l’enquête, avant le 7 octobre, Tsahal utilisait le terme de « cible humaine » pour désigner les commandants militaires haut-gradés du Hamas pour des frappes aériennes sur leurs domiciles, faisant de leurs familles des dommages collatéraux « acceptables » selon Israël. Cette restriction n’existe plus. Maintenant, chaque membre supposé du Hamas est répertorié par l’IA et fiché dans une « kill-list ».

Comme nous l’explique +972mag, « pendant les premières semaines de la guerre, l’armée s’est presque totalement appuyée sur Lavender, qui avait ciblé environ 37.0000 personnes suspectées — avec leurs domiciles — pour de potentielles frappes aériennes ». De plus, d’autres systèmes électroniques comme « Where’s Daddy ? » (« Où est Papa ? ») ont été utilisé pour lancer les attaques au moment où les cibles rentraient chez eux, le soir, auprès de leurs familles. On notera le cynisme de l’Etat israélien dans le nom des logiciels.

Un des militaires qui a témoigné au journal anglophone explique : « Nous n’étions pas intéressés de tuer des agents [du Hamas] seulement lorsqu’ils se trouvaient dans des locaux militaires ou au milieu d’opérations militaires. Au contraire, Tsahal les a bombardés chez eux sans hésitation. C’est beaucoup plus facile de bombarder une famille. Le système est construit de manière à rechercher ces situations ». En utilisant la rhétorique des « boucliers humains », Tsahal continue de légitimer la mort des femmes et des enfants sous ses bombardements.

Selon deux sources du journal, l’armée a aussi étendu le nombre de « dommages collatéraux acceptables » dans le cadre d’une attaque. Alors que l’armée n’autorisait pas de dommages collatéraux pour l’assassinat d’un militant de base du Hamas, avec Lavender, elle permet désormais de tuer de 15 à 20 civils, un chiffre qui peut aller jusqu’à une centaine de civil lors d’opération ciblant un général. Il s’agit d’un élément de plus qui prouve la volonté israélienne de faire de Gaza un champ de ruine, inhabitable, et de réduire drastiquement le nombre de Palestiniens sur le territoire.

20 secondes pour décider : la recette d’une opération génocidaire

Avec le soutien et la complicité des différentes puissances impérialistes, Israël se permet de créer une sorte de flux tendu génocidaire, une manière de renforcer l’efficacité, au prix de meurtres sanglants de civils, au nom de l’éradication du Hamas. En effet, Lavender a déjà reconnu une marge d’erreur évaluée à 10 % et de cibler des individus n’ayant que très peu, ou pas du tout, de lien avec le Hamas.

Ces données n’empêchent pas des décisions extrêmement rapides basées sur les prédictions de l’IA. Selon les sources, l’armée « ne dévouerait qu’environ « 20 secondes » pour chaque cible avant d’autoriser un bombardement — le temps d’être sûr que la cible est un homme ». L’adoption de ce mode de décision n’a pris que deux semaines pour l’armée israélienne avant que la « liste à tuer » définit par l’IA ne deviennent la ressource principale utilisée pour ces attaques.

Classées selon des méthodes statistiques expliquées dans le livre « The Human-Machine Team » (L’équipe Humain-Robot) écrit par le commandant de l’unité israélienne 8200, l’IA Lavender se sert des données de surveillance pour pallier le problème des limites du travail humain dans l’identification des cibles. Selon les sources de +972mag, les décisions de l’IA se basent sur les listes de Palestiniens répertoriés à l’aide du système israélien de surveillance de masse. Une méthode qui, selon le journal, « substitue l’activité humaine et la précision pour la création de cibles massives et la létalité ».

L’enquête révèle aussi l’utilisation massive de « dumb bombs » (bombes débiles), des missiles coûtant bien moins chers à Israël et faisant des dégâts plus importants, en entrainant donc dans la mort beaucoup plus de victimes. Un choix assumé par Tsahal qui, selon les sources du journal, autoriserait des attaques « sans considérations pour les dommages collatéraux ».

Une politique de la terreur sur les Palestiniens, à l’aide de l’IA

Lors d’une opération menée pour assassinat Ayman Nofal, commandant d’une des brigades du Hamas, une source explique l’armée israélienne aurait autorisé le massacre d’environ 300 civils ainsi que la destruction de plusieurs bâtiments du camp de réfugiés d’Al-Bureij. Un des résidents du camp, Aéro Al-Khatib, explique à « +972mag » qu’ « entre seize et dix-huit maisons ont été rasées pendant l’attaque. Nous ne pouvions différencier un appartement d’un autre — tout était mélangé sous les décombres et nous avons trouvé des restes humains partout ».

Si l’armée israélienne continue d’utiliser le prétexte du 7 octobre dans la légitimation de sa politique génocidaire à l’encontre des Palestiniens, il apparaît clairement que les IA sont utilisées à des fins de terreur, pouvant cibler des milliers de personnes pour les éradiquer en quelques secondes. Une politique qui est appuyée par les puissances impérialistes à l’image des Etats-Unis où des fonds d’investissement comme Ibex Investors financent des start-ups de cybersécurité, des logiciels ou encore des infrastructures. C’est aussi le cas d’entreprise comme Elbit System qui fournit des drones et des outils de surveillance, dont les données sont utilisées par Israël pour bombarder Gaza.

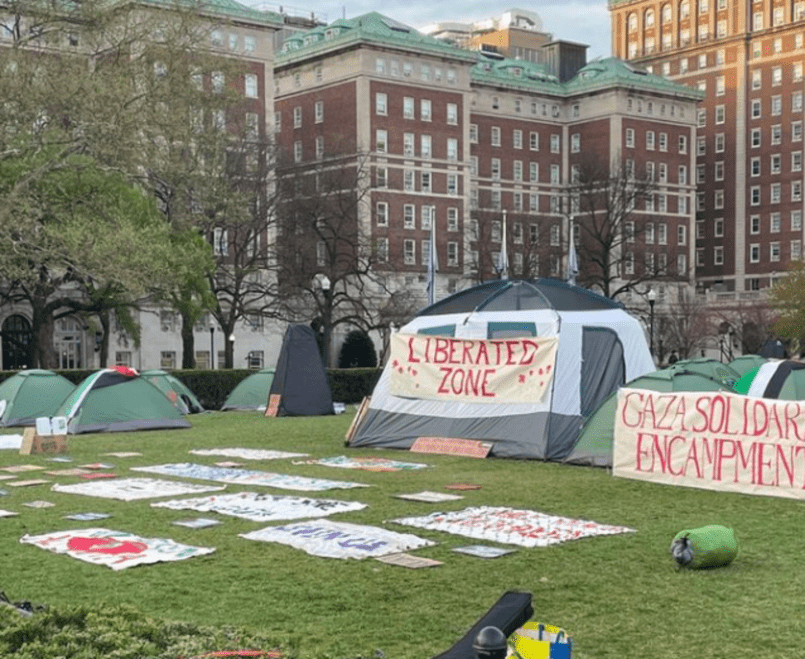

Dans l’escalade guerrière et le renforcement militariste actuelle, l’utilisation des intelligences artificielles pour renforcer les armées des pays en guerre tend à de plus en plus se démocratiser, qu’importe, comme on l’a vu, le coût humain. Plus que jamais, il est essentiel d’apporter sa solidarité avec le peuple palestinien et de se mobiliser pour mettre fin à la guerre e au génocide en cours et soutenir le droit à l’auto-détermination du peuple palestinien.